Shewhart, i soprammobili, i cavatappi, gli apriscatole

(ovvero “the great control chart swindle”)

(ovvero, il non-corso gratuito sulle carte di controllo)

Tutti certamente conoscono Walter Andrew Shewart… ehm… no?

Allora tocca presentarlo, visto che molti (troppi) non lo conoscono bene ma ripetono il suo nome più o meno a pappagallo (nella speranza di fare qualche soldo con corsi e consulenze sulle sue più famose “carte” o nella disperazione di credere di doverle per forza usare nei laboratori, per il compiacimento dei venditori di corsi e consulenze).

Nato a fine ‘800, venne definito (ma non per questo, visto che la statistica ci insegna che molto probabilmente nacque giovane) “il nonno della qualità totale” (“the grandfather of total quality management and process improvement”). Una specie di Lino Banfi, insomma, ma vissuto molto prima. Chi sarà invece “the godfather of quality”..?

Per alcune cose (non necessariamente per le sue carte di controllo) possiamo ringraziarlo: i suoi primi studi riguardarono il miglioramento delle comunicazioni telefoniche (sì, sappiamo che questo ha portato in seguito alle chiamate moleste dei venditori di contratti telefonici, luce e gas, ma lui non poteva saperlo). In precedenza aveva studiato la produzione degli interruttori, e i loro difetti.

La cosa però veramente importante che il nostro “nonno qualità” intuì e poi dimostrò fu che la continua regolazione dei processi di produzione peggiora la qualità dei prodotti, invece di migliorarla. Un po’ come introdurre inutili carte di controllo, che richiedono attenzione e manutenzione, tempo, denaro speso in corsi, redazione di procedure, espongono a rilievi di ispettori talebani, in un laboratorio che sta già funzionando abbastanza bene.

Insomma, soprammobili possono essere gradevoli alla vista ma accumulano polvere, acari, batteri. Ecco un soprammobile.

Un’altra intuizione di nonno Shewhart (questa più simile alla scoperta dell’acqua calda nel Pleistocene) fu quella riguardante le cause di variazione, da suddividere in “naturali” o “intrinseche” o “comuni” da una parte e in “anomale”, “occasionali” o “inattese” dall’altra. Ovvero? Facile: da una parte possiamo discutere di quanto sia piovoso questo mese di maggio (più o meno rispetto ad altri mesi di maggio è tutto da stabilire) mentre da un’altra ci stupiremmo assai di una nevicata a metà luglio.

“Non ci sono più le mezze stagioni, signora mia”

Ebbene, il buon Shewhart iniziò ad esaminare con attenzione le fluttuazioni intrinseche, “normali”, dei processi, tralasciando l’imprevedibile o l’anomalo (a questo ci pensò Murphy con le sue celebri “leggi”, molto dopo), ed arrivò a concludere che tenerle sotto controllo sarebbe stata una buona idea (evidentemente sottovalutando Murphy).

E cosa notò in particolare? Un fenomeno interessante: la distribuzione delle fluttuazioni, anche “naturali”, non era invece (e non è tuttora) “normale” né “gaussiana”. Interessante.

E, nel frattempo, cosa continuò a fare? Ovviamente, essendo in fin dei conti un buon Travet, a lavorare fino alla pensione per la compagnia Bell (come diceva Beppe Grillo ricevendo per questo alcune querele quando ancora faceva il comico, prima di diventare un clown: “una delle tante associazioni a delinquere di stampo telefonico”). Una di quelle compagnie che ci molestano quasi ogni giorno e ci spennano ogni mese. (Esistono entità forse ancora più malvage degli enti di accreditamento, là fuori.)

Ma noi continueremo a dire loro “TU NON PUOI PASSARE!”

Ah, fra le altre cose non dimentichiamo che Shewhart fornì al buon Deming l’idea della famosa “ruota”, che quest’ultimo divulgò abbondantemente. PDCA, miglioramento, quella roba lì, insomma.

Comunque, abbiamo capito: Shewhart lavorò per tutta la vita nell’ambito della PRODUZIONE, in particolare nell’installazione dei sistemi di commutazione telefonica.

Nella produzione manifatturiera le carte di controllo sono come i cavatappi quando si va in campeggio e ci si porta dietro una bottiglia buona: non si capisce quanto siano utili, prima di averli o se non li si ha a disposizione. E nei laboratori, invece? Che c’entrano le carte di controllo con i laboratori? C’entrano davvero? Mah, proviamo a scoprirlo…

Innanzitutto partiamo da una frase celebre del nostro “nonnino”:

“Contesto”. Interessante, saranno per caso simili il contesto di un laboratorio e quello di una produzione manifatturiera? Di che dati si tratta nei due casi, peraltro? Non si direbbe che i contesti siano simili. Tanto per fare un esempio il laboratorio ha bisogno di operatori competenti in ogni funzione. La manifattura no.

Consideriamo anche il necrologio del poro nonno Shewhart, scritto da Deming: “egli conosceva la delusione e la frustrazione, dovute all’incapacità di molti scrittori di statistica matematica di comprendere il suo punto di vista”. Azzeccatissimo. Ancora oggi c’è chi diffonde malamente il suo pensiero, fuori contesto, per dubbie finalità, a danno dei laboratori (che di norma hanno problemi, tanti, da risolvere, ben diversi da quelli delle manifatture industriali).

“E pensare che salutava sempre”

Vediamo un po’ adesso cosa ci dicono le norme che al nostro Scarpacuore sono dedicate: la ISO 7870-2 (attualmente nella seconda edizione del 2023) “Shewhart control charts”, ma soprattutto la capostipite della serie, la ISO 7870-1 (attualmente nella seconda edizione del 2014). Partiamo dalle prime pagine, che di solito sono le più interessanti. Nella propria introduzione la prima parte della norma ci dice che “ogni produzione, servizio o processo amministrativo possiede una certa variabilità, dovuta ad un gran numero di cause”. Lapalissiano. E in effetti si parla anche di “servizi”, e quello del laboratorio è certamente un “servizio” (o forse una produzione di dati analitici, o forse uno strano ibrido: non importa, i laboratoristi sapranno riconoscere il “contesto”, i guru chissà).

Ma, attenzione, sembrerebbe che i redattori della norma (e magari anche il buon Shewhart) avessero in mente produzioni e servizi erogati “in serie”. Il laboratorio analizza sì “serie” di campioni, ma ogni risultato è un risultato a sé stante. Confusione in agguato, e c’è chi ci è cascato. Vediamo di non farne altra, e di rimettere un po’ in ordine le cose.

Se è vero che “i risultati osservati di un processo sono, come risultati, non costanti” (sempre dall’introduzione della ISO 7870-1), non dovremmo attivare il corto circuito (Shewhart, da esperto di interruttori, probabilmente non apprezzerebbe) consistente nel confondere il “risultato” di una produzione o di una erogazione di servizi (probabilmente la qualità degli interruttori o quella delle telefonate moleste che cercano di venderci abbonamenti telefonici) con il “risultato” di un’analisi o di una prova. Nel secondo caso dovremmo pensare alla “qualità del dato”, non al dato in sé, come “risultato osservato di un processo”.

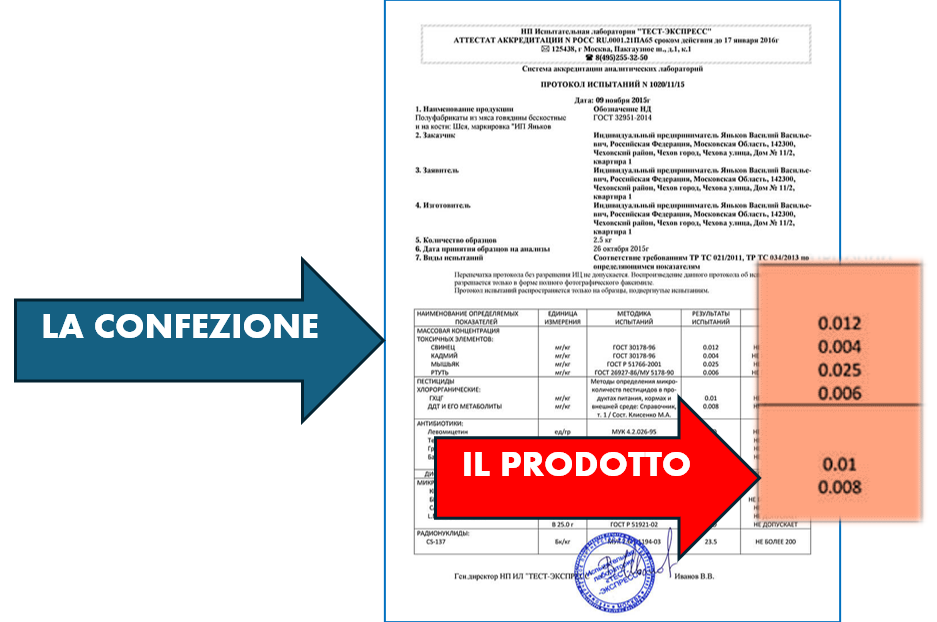

Il “prodotto” del laboratorio È il risultato analitico. È IL DATO ANALITICO (anche se ci è capitato di ascoltare tizi noiosi in vari convegni e conventicole blaterare con quell’accento tipico degli autoproclamati guru “eeeh… il proodooottooo dei laboratoooriii… è il rappooortooo di proovaaa”: niente di più sbagliato, il prodotto del cioccolataio è l’uovo di Pasqua, non il cellophane colorato che lo circonda e lo veicola). Ripetiamolo: il “prodotto” del laboratorio è IL DATO ANALITICO. Dovrebbe essere chiaro in tutte le lingue del mondo.

Non dobbiamo mai dimenticarlo, se non vogliamo finire a dipendere dai vari specchietti per allodole e fogli di calcolo colorati sparsi in giro. Esistono indubbiamente forme più divertenti di tossicodipendenza.

E in cosa consiste la “qualità del dato”? Crediamo abbia a che fare con la sua precisione, accuratezza, sensibilità, specificità, tempestività di fornitura, rappresentatività, basso costo di ottenimento e quindi prezzo per l’utilizzatore. Forse su questo si potrebbe ragionare. Vediamolo.

La “variabilità” che destò l’interesse di Shewhart e che l’introduzione alla ISO 7870-1 cita, potrebbe essere dunque, nel caso dei laboratori, LA VARIABILITÀ della precisione e dell’accuratezza (i dati prodotti da un laboratorio potrebbero diventare meno precisi e meno accurati nel tempo, per vari motivi, e questa precisione e accuratezza potrebbero variare, oscillare, nel tempo, magari anche in meglio). Ricordiamoci però che, in qualche modo, anche precisione e accuratezza sono esse stesse delle variabilità, ma del risultato analitico. Attenzione sempre a non confondere, ci sono i guru della qualità per questo.

La VARIABILITÀ potrebbe essere quella della sensibilità e specificità (comunque le vogliamo chiamare, si tratta del valore minimo rilevabile e della capacità di evitare interferenze), oppure quella della tempestività di fornitura, o forse quella della rappresentatività, e magari quella del costo. Che sia importante scegliere le caratteristiche giuste che dovremmo misurare sul processo ce lo dice la stessa ISO 7870-1, al paragrafo 5.6: “l’elemento più importante della raccolta dati è la selezione delle caratteristiche da studiare e l’identificazione dei punti in cui controllarle”.

Per fare questo occorre una buona “comprensione della natura del processo e dei dati da raccogliere” (che forse i laboratoristi hanno, non siamo invece sicuri l’abbiano gli “esperti di rischio” e altri simili strani soggetti). Infine occorrerà scegliere “caratteristiche che riflettano fortemente lo stato del processo” e che “siano correlate alle caratteristiche di qualità del prodotto” (o servizio, nel nostro caso il dato analitico prodotto).

Attenzione, non smetteremo di ribadirlo: si tratta di misurare le variazioni del processo di produzione del dato analitico. Niente a che vedere con il dato analitico in sé e con le sue possibili variazioni, tra un campione e un altro.

Esaminiamo innanzitutto la possibile variabilità del costo di ottenimento del dato analitico, e quella conseguente del prezzo. Non abbiamo certamente bisogno di carte di controllo per affrontare questa questione. Le dinamiche di mercato e le analisi economiche bastano ed avanzano. L’esperienza insegna poi abbondantemente che il costo di produzione di qualsiasi dato analitico tende sempre a diminuire con il tempo, con soddisfazione di chi il dato produce e di chi il dato utilizza, e che la componente “umana” di tale costo diminuisce altrettanto.

Capitolo “rappresentatività”. Certamente questa può variare, ma altrettanto certamente non per un’evoluzione temporale. Sappiamo bene che la rappresentatività di qualunque dato analitico dipende dal campionamento, dalla sua capillarità ed estensione. Di nuovo, le carte di controllo non sembrano essere (e non sono) lo strumento appropriato di indagine e di garanzia di qualità.

E i tempi di fornitura? Su questo si può ragionare, sempre che effettivamente interessino al cliente. lo faremo verso la fine dell’articolo. Ma senza carte di controllo.

Rimangono le variabilità della precisione, accuratezza, specificità e sensibilità, in definitiva quelle della “affidabilità” di questo benedetto dato analitico (diciamo “benedetto”, perché sembra essere l’ultima cosa che interessa agli addetti ai lavori della “qualità”, quelli che campano sulle spalle dei laboratori, e non solo di questi ultimi). Su queste variabilità quindi ci concentreremo, anche perché, se ben leggiamo quanto riportato nella ISO 17025 al punto 7.7.1, l’unico che cita le “carte di controllo”, queste si usano, “ove applicabile”, laddove disponiamo di “campioni di lavoro o di verifica”.

Sottolineiamo: OVE APPLICABILE.

Sottolineiamo: CAMPIONI DI LAVORO O DI VERIFICA.

No z-score, no indicatori di processo, no risultati di tarature, no mille altre cose che tentano di convincerci a mettere su carta di controllo.

È vero: i campioni di lavoro e verifica possono, se analizzati in ripetizione (in doppio, ad esempio) o ad ogni ciclo analitico, fornirci qualche informazione inerente la precisione e l’accuratezza dei nostri dati.

Ma è veramente utile un’elaborazione statistica sofisticata (complessa, costosa) di questi dati, dei risultati del campione di controllo che inseriamo nel ciclo analitico? Servono veramente X, Z, R, p, np, c, u, multivariate, tendenze, campo mobile, errori alfa e beta, ed altri strumenti sofisticati? Servono le famigerate carte di controllo di Shewhart?

Di solito l’utilità pratica è come quella dei soprammobili. Utili (più o meno) quando siamo un po’ in difficoltà economica viene a trovarci la vecchia zia zitella con un discreto conto in banca (potrebbe anche essere un’ispettrice, chissà). In quel caso vanno rispolverati accuratamente e messi in bella vista. Lo stesso si fa abitualmente con le carte di controllo, in prossimità delle verifiche di accreditamento. Spolverare e mettere in bella vista. Decisamente diverso è però il flusso monetario nei due casi.

E non dimentichiamo un paio di fatti innegabili: se ci concentriamo su un indicatore della precisione come la ripetibilità, rappresentata ad esempio dalla differenza dei due risultati di una prova in doppio:

- Questa differenza può certamente aumentare, ma non può mai scendere sotto lo zero; spesso è proprio zero;

- Nel 5% dei casi, ovvero una volta su venti, questa differenza supererà il limite di ripetibilità (essendo per definizione il limite di ripetibilità proprio quel valore entro il quale ricade tale differenza nel 95% dei casi).

Questi fatti rendono certamente il “contesto” del laboratorio ben diverso da quello della produzione manifatturiera, in quanto:

- È pur vero che ad esempio il tasso di difettosità di un lotto di prodotto può aumentare (fino al 100% del campione esaminato) e non potrà mai scendere sotto zero, similmente alla differenza tra i due valori della prova in doppio MA non possiamo certamente intendere la differenza dei risultati della prova in doppio come qualcosa di simile al tasso di difettosità;

- Si deve considerare il fatto che alla fine il dato analitico è accompagnato da un’indicazione di incertezza che di solito è nettamente superiore rispetto al possibile incremento di “imprecisione” dato dalla fluttuazione della ripetibilità.

Non si tratta di cavatappi (o di tappi) che potrebbero rompersi quando si tenta di stappare una bottiglia.

“Eh ma nei corsi ci hanno spiegato che…, con tanti bei grafici colorati… Le carte di controllo servono a tenere sotto controllo questo e quello…”

Superstizione. Fateci caso: riuscivate, e riuscireste tuttora, a tenere sotto controllo questo, quello, e pure quell’altro ancora, anche senza carte di controllo. Non state gestendo la produzione di tappi o cavatappi. Chi tenta di convincervi del contrario diffonde superstizione: se si entra nel campo dell’imbonimento preferiamo il Mago Otelma ai guru della qualità. Almeno è più colorato ed è anche divertente, purché si eviti di credergli sul serio.

I guru della qualità tendono di solito a non essere nemmeno divertenti.

Ma torniamo alla nostra ISO 7870-1 e alle indicazioni sull’uso delle carte di controllo. Un lungo capitolo della norma, il quinto, quello sui “concetti”, tratta questi ultimi in modo approfondito, iniziando a spiegarci cosa sono queste carte. È chiaro dal principio che esse riguardano i “valori di una caratteristica di articoli o elementi”. Nel caso dei laboratori gli “articoli o elementi” suddetti corrisponderanno ai risultati analitici che il laboratorio fornisce, le “caratteristiche” alla loro precisione, accuratezza, sensibilità, specificità. Si aggiungono poi altri concetti ben noti, quello della “linea centrale”, ovvero il valore attorno al quale le caratteristiche (sempre precisione, accuratezza, sensibilità, specificità) varieranno, quello dei “limiti di controllo” che rappresentano i limiti estremi ammessi di variazione delle caratteristiche e che vengono utilizzati per valutare il livello di controllo del processo (nel caso dei laboratori si tratterà del processo di produzione dei dati analitici).

Un superamento dei limiti di controllo potrebbe indicare che qualche fonte anomala (occasionale, inattesa) di variabilità. In questo caso la norma 7870-1 suggerisce come alternative di intervento l’indagine sulle cause di anomalia, la regolazione del processo, il blocco del processo, perfino il tentare di consolidare l’anomalia, qualora la fortuna ci abbia fatto inciampare accidentalmente in un miglioramento del processo. Ci suggerisce anche l’accettazione del rischio di proseguire. Avete capito bene: si può accettare il rischio. Ma forse non tutti lo sanno…

Aaargh! C’è un punto fuori! Cosa (non) avete fatto! Maledetti! Non conformità! Anatema! Scomunica! Iscrizione forzata alla prossima Conference League!

La norma ci dice poi che possono anche essere previsti “limiti di allerta”, più restrittivi rispetto a quelli di controllo, il cui superamento potrebbe suggerirci di incrementare il “campionamento” (quello della misura di caratteristiche della produzione, ad esempio nel caso dei laboratori l’inserimento di più campioni di controllo in linea).

Un processo “in controllo statistico” è soggetto solo a variazioni casuali ma prevedibili che portano a variazioni altrettanto casuali e prevedibili dei suoi esiti (prodotti, servizi)

Nel caso un processo sia “fuori controllo statistico” si manifestano invece variazioni anomale, occasionali, inattese, non prevedibili (ma non è detto che ciò debba necessariamente a portare ad esiti non conformi (prodotti, servizi)

Questo ci dice la norma. Attenzione: non necessariamente un processo fuori controllo porta ad esiti non conformi, e questa è un arma a doppio taglio (potremmo non accorgerci in tempo del disastro imminente, in quanto tutto sembrerà andare bene).

Le derive

E veniamo alle derive (naturali e non). La ISO 7870-1 non ci dice molto a proposito, solo che è possibile rilevarle e correggerle, mantenendo quindi il controllo, facendo al contempo in modo di non effettuare regolazioni eccessive (ricordiamo che il buon Shewhart aveva scoperto che la continua regolazione dei processi di produzione peggiora la qualità dei prodotti, o servizi, invece di migliorarla).

Le decisioni

A un certo punto occorrerà pur prenderne, se si sospetta una perdita di controllo. Ma, lo sappiamo bene, chi non fa non falla, e si rischia di sbagliare. Esistono due tipi di errore: quello di tipo I (o alfa) porta a ritenere fuori controllo un processo agendo quindi su di esso senza che ve ne fosse effettiva necessità; quello di tipo II (o beta) è più subdolo, esso interviene quando sembra che il processo sia sotto controllo ma così non è, anche se i dati sembrano confermarlo.

Abbiamo l’impressione, corroborata da quanto ci riferiscono i laboratori, che l’errore di tipo alfa sia il più frequente: l’utilizzo delle carte di controllo porta spesso a pensare che il processo analitico sia fuori controllo, quando ciò non è, mentre, sempre nei laboratori, spesso incombono minacce impercettibili e i dati sembrano negare la loro presenza (errori beta). Ad esempio i laboratori spesso credono che un controllo casuale degli errori di trascrizione mantenga sotto controllo il processo di trasferimento dei dati, e magari costruiscono inutili carte di controllo che riportano il numero di errori rilevati (di solito zero, d’altronde pescare a mani nude in un lago non è un buon modo per arrivare a credere che nel lago non vi siano pesci, visto che non ne abbiamo preso neanche uno). Finché non perdono il loro migliore cliente per un errore di trascrizione fatto sul campione sbagliato, nel momento sbagliato, magari dovendogli pagare i danni.

La misura del processo

Il controllo del processo (sempre di produzione del dato analitico, nel nostro caso) si basa su una valida misura delle prestazioni del processo stesso, ci dice la ISO 7870-1. Attenzione ancora una volta al possibile equivoco (in cui ci pare siano caduti a piè giunti certi “esperti”): la produzione del dato analitico da parte del laboratorio è già essa stessa una “misura” (delle caratteristiche del campione analizzato) ma qui si introduce un’altra ben diversa “misura”: quella delle prestazioni del processo analitico, in pratica la “misura delle prestazioni del processo di misura”. Della variabilità di questa “misura di secondo ordine” tratta un’altra norma ISO sul controllo dei processi, la 22514-7, “Capacità o funzionalità dei processi di misura”, attualmente in seconda revisione del 2021 (anche se qualcuno pare non essersene ancora accorto…).

Un’altra norma?!

Un altro cavatappi? Ma noi abbiamo portato lattine di birra, che ce ne facciamo di un cavatappi? Piuttosto ci serve un apriscatole, per il tonno con cui condire la pasta! Dove diavolo è finito?

Non preoccupiamocene troppo, in fin dei conti questa ennesima norma-cavatappi è solo un bignamino delle varie norme e guide sull’incertezza (per stimare la quale abbiamo già a disposizione numerosi coltellini svizzeri multiuso), riportante un titolo esotico come “capability”, probabilmente utile a permettere roboanti orazioni ai soliti guru. Praticamente una versione aggiornata del latinorum di Don Abbondio. Per evitare di far la fine di Renzo ricordiamoci che la parola misteriosa significa solo “criteri di accettabilità della misura effettuata”. In pratica la norma ci spiega, in circa sessanta pagine sessanta, come scegliere un metodo di misura adeguato per un determinato scopo, in base alla sua incertezza. Caso mai non fossimo in grado di farlo, prima. Ricordiamoci che comunque stiamo sempre parlando di questa “misura del secondo ordine”.

E per quella del primo ordine, ovvero la nostra analisi di laboratorio? Beh, forse un’idea di quanta precisione, accuratezza, eccetera, sia richiesta in funzione dell’utilizzo dei dati analitici già ce l’abbiamo, no? Senza bisogno di altre norme!

E quindi, le carte di controllo quanto potrebbero servire, in laboratorio?

Più o meno quanto a un pesce serve una bicicletta, come nella celebre pubblicità della birra Guinness.

Oppure quanto a un laboratorio può servire la norma ISO 10012 (vedere cosa dice la norma stessa nell’introduzione).

A qualcuno però le carte di controllo sono servite, e servono tuttora. Immaginiamo un laboratorio con tanti, ma tanti strumenti, tutti funzionanti 24/24, 7/7, o quasi. Un “risultatificio”. Ovviamente (o almeno si spera) i campioni “macinati” in serie saranno accompagnati da una serie di controlli in linea (bianchi, standard secondari, campioni ripetuti, eccetera) e tarature, come previste dal metodo di analisi impiegato. Questi campioni di controllo “consumeranno” parte del tempo-macchina. Se, poniamo, ogni 20 minuti il macchinario tratta un campione, esso produrrà 72 risultati ogni giorno, 504 risultati alla settimana. Se ogni analisi viene venduta a, poniamo, 50 euro, la massima resa potenziale è di 25.200 euro a settimana. Ma i controlli sottrarranno tempo-macchina. Se, poniamo, ogni 10 campioni occorre inserire un controllo, e ogni giorno occorre ripetere la taratura, poniamo a 5 punti più un bianco, i campioni “utili” giornalieri diventano 60, quelli settimanali 420. Il fatturato effettivo settimanale scenderà a 21.000 euro. Sempre un buon risultato ma… Se si cercasse di ridurre i controlli rispetto a quanto previsto dal metodo, magari riducendo la taratura a settimanale e i controlli a uno ogni 30 campioni, i campioni “utili” settimanali rimasti sarebbero 482, quindi 62 in più, per un valore di 3.100 euro in più. Interessante, no? Potrebbe quindi valere la pena di implementare un sofisticato sistema di carte di controllo, pagare magari un consulente (ma uno bravo) un 3.000 euro per lo studio una tantum la prima settimana (avete chiamato? eccoci!) e incassare 3.000 euro in più per ciascuna delle rimanenti 51 settimane dell’anno.

Ecco un buon cavatappi con cui stappare un barolo d’annata. Uno “Scarpacuore” del 2004.

Come dite? Voi 504 risultati non li fornite nemmeno in un anno? Allora con le carte di controllo vi siete comprati un sofisticato cavatappi da sommelier mentre vi serviva un apriscatole per la scatoletta di tonno. Che non avete. E un accendino per stappare la “familiare” di Peroni.

Ma consolatevi: prima o poi nel risultatificio arriva l’ispettore che “eh ma il metodo EPA richiede questi controlli, non potete farne di meno: nonconformità! peppereppeppè!”.

E allora giù: altri 300 euro per la consulenza su come scrivere la doverosa riserva.

Torniamo ancora una volta alla ISO 7870-1. Essa ci fornisce indicazioni sulla frequenza di campionamento e dimensione dei campioni (sempre “al secondo livello”, ovvero relativamente a quante volte e con quale estensione bisogna controllare il processo analitico, in pratica quanti campioni di controllo inserire per ogni lotto, in un certo numero di lotti), tenendo conto dei costi e dei benefici. La norma passa quindi a descrivere due tipi di carte di controllo: “per attributi” e “per variabili”. Si intende “per attributi” una categorizzazione qualitativa (es. conforme/ non conforme, presenza/ assenza, nel nostro caso potrebbe essere la comparsa di un segnale di controllo), “per variabili” una distribuzione continua (come potrebbe essere un valore ottenuto dalla lettura di un campione di controllo). Riporta quindi l’indicazione secondo la quale la distribuzione delle caratteristiche misurate del processo, nel caso “per variabili”, sarebbe normale (gaussiana), contraddicendo il buon Shewhart, ma pazienza, proseguiamo. Nel caso “per attributi” sarebbe binomiale o poissoniana. Poco importa, alla fine.

La norma suggerisce saggiamente, nel caso del controllo “per variabili” di utilizzare due carte di controllo, una per la media o mediana, una per la dispersione attorno ad essa (evitando così il paradosso del pollo di Trilussa). Cosa potremmo utilizzare in laboratorio per questi scopi? Ragionevolmente, per quanto riguarda un campione di controllo inserito in doppio nel ciclo analitico, la media dei due valori ottenuti da una parte e la differenza tra di essi dall’altra. Ma come valuteremo la variazione della variazione della variazione? Useremo la media delle differenze delle prove in doppio? Ricordiamoci che:

- I metodi analitici applicati nel laboratorio hanno una propria ripetibilità, che è una stima della variabilità dei possibili risultati, di solito fatta inizialmente (prima variabilità);

- La differenza dei risultati di una prova in doppio è una stima della ripetibilità in un dato momento, per un certo lotto di campioni analizzati; essa è soggetta a variabilità (la seconda variabilità);

- L’evoluzione nel tempo di questa differenza, forse desumibile da una carta di controllo, è una stima di questa seconda variabilità.

Nel caso “per attributi” la norma di dice essere sufficiente una sola carta di controllo. Per fortuna.

Ma Shewhart quando arriva? Ci siamo quasi. Al paragrafo 6 la ISO 7870-1 inizia a raccontare dei vari tipi di carta di controllo e dei loro possibili utilizzi, fondamentalmente due, a seconda dello scopo che ci siamo prefissati: garantire la stabilità del processo, oppure stabilire se il processo è accettabile. Nel primo caso ecco a disposizione le carte di Shewhart, nel secondo ci servirà un’altra norma, la ISO 7870-3. Ma prima comunque dovremo utilizzare un po’ di Shewhart…

Se poi risultasse proprio impossibile tenere sotto controllo statistico il nostro processo ci sono altri metodi, non basati sull’elencazione dei santi del calendario accompagnata da espressioni colorite bensì su certi approcci che la ISO 7870-1 descrive nel proprio nono paragrafo, che tra breve tratteremo (ci pare essere il più interessante di tutti).

Non ci addentreremo invece oltre, almeno per ora, nei meandri della descrizione dei vari tipi e sottotipi di carta di controllo: quel che ci preme è dimostrare che, norme alla mano, al di là di certe fantasiose e luccicanti narrazioni circolanti, la lettura corretta delle indicazioni normative è la seguente:

- La ISO 17025 prevede l’utilizzo di carte di controllo solo laddove ciò sia applicabile e mediante utilizzo di campioni di lavoro o di verifica; negli altri casi si tratta di inutili soprammobili;

- La norma quadro sull’utilizzo delle carte di controllo, la ISO 7870-1, prevede l’utilizzo delle suddette per il controllo dei processi mediante la misura degli stessi; quello che si potrebbe misurare nei laboratori è essenzialmente il processo di produzione del dato analitico e ciò che si può misurare (o meglio, stimare) nel tempo sono precisione, accuratezza, sensibilità, specificità, tempi di produzione (o meglio, di fornitura);

- La norma ISO 22514-7 viene richiamata dalla ISO 7870-1 solo relativamente a questa “misurazione del processo”, quella di secondo livello; è chiaro che la ISO 22514-7 non è da intendersi come strumento valido per le valutazioni diretta della validità del dato analitico in sé: per questo ci sono già numerose norme e guide specifiche su validazione, verifica, incertezza, che i laboratori sono avvezzi ad usare; potrebbe semmai essere il cliente del laboratorio, l’utilizzatore del dato analitico, a fare delle proprie riflessioni basate su questa norma quando valuterà il proprio processo di produzione sulla base dei risultati analitici che il laboratorio gli fornirà, se si sarà in presenza di un campionamento statistico significativo della produzione stessa;

- Il laboratorio, nella propria “produzione” di dati analitici, è già soggetto ad una serie di obblighi più o meno stringenti sul rispetto della qualità del dato: la maggior parte dei metodi di analisi indica chiaramente i controlli da effettuare, la loro frequenza, gli interventi da attuare in caso l’esito sia sfavorevole; perché quindi cercare di ottenere chissà quale beneficio dall’utilizzo di strumenti in fin dei conti complicati quanto inadatti, come le carte di controllo? Per ridurre la frequenza dei controlli, forse? Ma non ci basta la competenza del tecnico, per questo?

Guarda un po’, Il capitolo nono della ISO 7870-1 va proprio in questa direzione: esaminiamolo.

Leggendo scopriamo, ad esempio, che “talvolta è impossibile condurre o mantenere un processo in stato di controllo statistico, alcune fonti di disturbo non possono essere eliminate o ridotte a sufficienza”.

Prendiamo ad esempio una tipica e ben nota fonte di disturbo, ovvero “arrivo di ulteriori campioni quando il laboratorio è già in saturazione”. Questa fonte certamente influirà sul parametro misurabile del processo “tempo di consegna dei risultati analitici”.

Posto che qualunque titolare di laboratorio di fronte a questa “fonte di disturbo” si sfregherà le mani

abbiamo qui un paradigmatico esempio di “sorgente di variazione non eliminabile” (e ben difficilmente “riducibile a livelli accettabili”: chi non ha un cliente rompiscatole-benefattore-del-venerdì-ore-cinque?).

La norma ci fa sapere che “le cause di questo disturbo possono essere sconosciute” (cosa mai passerà per la testa del soggetto che aspetta il venerdì nel tempo pomeriggio per portarci 50 campioni? “ah, mi servono per lunedì”) e che “la loro rimozione potrebbe essere costosa” (50 x 100 = 5.000 euro in meno in entrata), quindi ci suggerisce di “non usare carte di controllo”, bensì di “concentrarci sul mantenere il processo al suo livello di funzionamento target”. Per fare ciò si possono “utilizzare modelli predittivi più o meno complessi” (da “sappiamo che arriverà, sono già le 16,30” a “in media arriva un venerdì sì e uno no”) e “agire rapidamente evitare che il processo vada fuori dai valori stabiliti” (ovvero “abbiamo già i turni fatti, questa settimana il sabato tocca a te”).

Certo, seguendo i consigli (e soprattutto i corsi) dei nipotini della qualità totale (che il nonno se potesse sculaccerebbe volentieri), avremmo potuto impiegare un po’ di tempo (sottratto al lavoro di analisi) a misurare i tempi di consegna medi dei risultati, calcolare la loro deviazione standard, metterli su un grafico, per sapere che i risultati glieli possiamo dare al limite mercoledì (più o meno un giorno), tanto il soggetto li vorrebbe comunque per lunedì (per poi venire a dirci, alle 8 di lunedì sera, ottenuti faticosamente gli agognati dati, saltando cresime di lontani parenti e partite decisive per il campionato e rischiato un altro divorzio, “risultati? quali risultati? ah, quelli, no non erano poi così urgenti, DOMANI vi porto altri campioni”, che naturalmente slitteranno poi al venerdì pomeriggio successivo).

Sì, ma se dobbiamo vedere quando cambiare una colonna… Ci ha detto l’ispettore che se mettiamo su carta di controllo il numero di piatti teorici, la risoluzione dei picchi…

Interessante. Davvero. Vogliamo il numero di telefono di quello scienziato, così magari ci facciamo una foto con lui e ce ne vantiamo con gli amici del calcetto. Mettendo su una dozzina di carte di controllo scopriremmo (chi l’avrebbe mai detto!) che la risoluzione della colonna diminuisce col tempo, e continueremmo a cambiarla quando dall’esame dei cromatogrammi risulterà che la colonna ormai non funziona più. Costo di una colonna GC: circa 800 euro. Tempi di consegna indicati sui siti web dei vari produttori: pochi giorni. Se il consumo medio è di una colonna all’anno e con la magia delle carte di controllo riuscissimo ad estendere la durata di una settimana (ma così non è: la colonna sfinita va cambiata comunque), risparmieremmo una quindicina di euro. All’anno. Quattro centesimi al giorno, circa. Certamente, vale la pena dedicare il nostro tempo a elaborare e compilare sofisticate carte di controllo. Oh sì.

E l’applicazione delle carte di controllo alle tarature, ai “processi”, ai risultati dei circuiti interlaboratorio, e altre belle invenzioni?

Inutile anche in questo caso, a meno che, come detto, non riteniate queste attività in qualche modo simili alla produzione massiva, manifatturiera o di servizi. A noi non sembra. Per le tarature valgono considerazioni simili a quella sviluppata poc’anzi sulle colonne per cromatografia. Per quanto riguarda i circuiti interlaboratorio non esiste più alcun obbligo di utilizzare carte di controllo (l’assurda prescrizione che era presente nel documento RT 08 in questo senso è stata giustamente estirpata dall’ultima edizione, e la guida Eurachem PTP del 2021 in fin dei conti ne sconsiglia l’uso, essendo gli z-score influenzati da innumerevoli fattori esterni al laboratorio). Della “produzione” del dato analitico abbiamo detto. “Producete” forse tarature in serie? C’è qualcos’altro che fate in laboratorio, oltre alla “produzione” del dato analitico, che in qualche modo somiglia a una “produzione”? Se no le carte di controllo nel vostro caso non sono altro che un inutile e spesso costoso soprammobile.

In definitiva, se volete mettere un soprammobile in bella mostra, perché ci tenete a fare bella figura con la vecchia (noiosa) zia, fate pure, ma ricordate che poi dovrete ricordarvi di togliere la polvere. Se ci tenere a usare un cavatappi come soprammobile va altrettanto bene, ma magari è più complicato da gestire. Però prima vedete se vi basta cercre un apriscatole (ed evitare i rompiscatole) per aprire la scatoletta di tonno: magari evitate di spendere inutilmente soldi e tempo in soprammobili, aspirapolvere, cavatappi ultrasofisticati.

Del resto non ne avete nemmeno spesi per questo non-corso gratuito sulle carte di controllo di Shewhart. O di Scarpacuore, se preferite. Fateci sapere se vi è piaciuto, nei commenti. Se poi volete un attestato di partecipazione al non-corso, chiedetecelo.

Commenti recenti